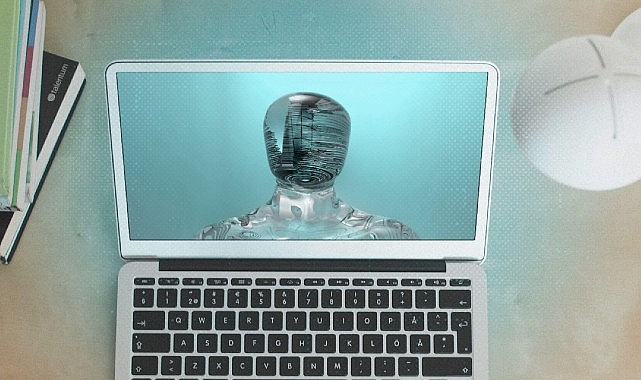

Yapay zekâ asistanınıza güvenmeden evvel iki kere düşünmelisiniz çünkü data tabanı zehirlenmesi asistanınızın çıktılarını değerli ölçüde hatta tehlikeli bir biçimde değiştirebilir. Siber güvenlik şirketi ESET güvenlik, zımnilik ve itimattan ödün vermeden yapay zekânın potansiyelini nasıl ortaya çıkarabilirizi araştırdı, tekliflerini paylaştı.

Sürekli ortaya çıkan sayısız güvenlik açığından da görebileceğimiz üzere çağdaş teknoloji kusursuz olmaktan çok uzak. Tasarım açısından inançlı sistemler tasarlamak denenmiş ve doğrulanmış bir en âlâ uygulama olsa da bunu yapmak kaynakları kullanıcı tecrübesi (UX) tasarımı, performans optimizasyonu ve öbür tahliller ve hizmetlerle birlikte çalışabilirlik üzere öbür alanlardan uzaklaştırabilir. Bu nedenle, güvenlik ekseriyetle art planda kalır ve sırf taban uyumluluk gerekliliklerini yerine getirir. Bu değiş tokuş bilhassa hassas datalar kelam konusu olduğunda tasa verici hale gelir zira bu çeşit datalar kritiklikleriyle orantılı muhafazalar gerektirir. Günümüzde, yetersiz güvenlik tedbirlerinin riskleri, bilgilerin fonksiyonelliklerinin temelini oluşturduğu yapay zekâ ve makine tahsili (AI/ML) sistemlerinde giderek daha besbelli hale gelmektedir.

Veri zehirlenmesi nedir?

Yapay zekâ ve makine tahsili modelleri, kontrollü ve kontrolsüz öğrenme yoluyla daima olarak güncellenen temel eğitim bilgi kümeleri üzerine inşa edilir. Makine tahsili yapay zekânın gelişmesinde kıymetli rol oynar. Makine tahsili sayesinde gerçekleşen derin öğrenme, öbür etkenlerle birlikte yapay zekânın yeteneklerini ilerletmesini mümkün kılar. Datalar ne kadar çeşitli ve emniyetli olursa modelin çıktıları da o kadar hakikat ve kullanışlı olacaktır. Bu nedenle, eğitim sırasında bu modellerin büyük ölçüde bilgiye erişmesi gerekir. Öte yandan, doğrulanmamış yahut güzel incelenmemiş data kümeleri güvenilmez sonuçların ortaya çıkma mümkünlüğünü artırdığından bilgi yığınlarına güvenmek riskleri de beraberinde getirmektedir. Üretken yapay zekânın, bilhassa de büyük lisan modellerinin (LLM’ler) ve bunların yapay zekâ asistanları formundaki uzantılarının, modelleri makus niyetli emellerle kurcalayan taarruzlara karşı bilhassa savunmasız olduğu bilinmektedir. En sinsi tehditlerden biri, düşmanların modelin davranışını değiştirmeye çalıştığı ve yanlış, önyargılı ve hatta ziyanlı çıktılar üretmesine neden olduğu data (veya bilgi tabanı) zehirlenmesidir. Bu cins tahrifatların sonuçları uygulamalar ortasında dalgalanarak itimadı sarsabilir ve hem beşerler hem de kuruluşlar için sistemik riskler doğurabilir.

Veri zehirlenmesi türleri

Veri zehirleme akınlarının çeşitli çeşitleri vardır, örneğin:

· Veri enjeksiyonu: Saldırganlar, bir yapay zekâ modelinin davranışını değiştirmesini sağlamak için eğitim datalarına makûs emelli bilgi noktaları enjekte eder. Çevrimiçi kullanıcıların Tay Twitter botunu saldırgan tweetler atacak halde yavaşça değiştirmesi buna yeterli bir örnektir.

· İçeriden taarruzlar: Normal içeriden tehditlerde olduğu üzere, çalışanlar erişimlerini berbata kullanarak bir modelin eğitim setini değiştirebilir, davranışını değiştirmek için modül parça değiştirebilirler. İçeriden hücumlar bilhassa sinsidir zira legal erişimden faydalanırlar.

· Tetikleyici enjeksiyonu: Bu hücum, bir tetikleyici oluşturmak için yapay zekâ modelinin eğitim setine bilgi enjekte eder. Bu, saldırganların bir modelin güvenliğini aşmasına ve belirlenen tetikleyiciye nazaran durumlarda çıktısını manipüle etmesine imkan tanır. Bu taarruzun tespit edilmesindeki zorluk, tetikleyicinin tespit edilmesinin sıkıntı olabilmesinin yanı sıra tetikleyici etkinleştirilene kadar tehdidin uykuda kalmasıdır.

· Tedarik zinciri saldırısı: Bu hücumların tesirleri bilhassa fecî olabilir. Yapay zekâ modelleri çoklukla üçüncü taraf bileşenleri kullandığından tedarik zinciri sürecinde ortaya çıkan güvenlik açıkları sonuçta modelin güvenliğini tehlikeye atabilir ve onu istismara açık hale getirebilir.

Yapay zekâ modelleri hem iş hem de tüketici sistemlerine derinlemesine gömüldükçe asistanlar yahut verimlilik artırıcılar olarak hizmet verdikçe bu sistemleri amaç alan hücumlar kıymetli bir tasa kaynağı haline geliyor. Kurumsal yapay zekâ modelleri bilgileri üçüncü taraflarla paylaşmasa da çıktılarını güzelleştirmek için şirket içi bilgileri silip süpürmeye devam ediyor. Bunu yapmak için hassas bilgi hazinesine erişmeleri gerekir, bu da onları yüksek pahalı amaçlar haline getirir. Çoklukla hassas bilgilerle dolu olan kullanıcı komutlarını başka taraflarla paylaşan tüketici modelleri için riskler daha da artmaktadır.

Makine tahsili ve yapay zekâ gelişimi nasıl teminat altına alınır?

ML/AI modelleri için önleyici stratejiler hem geliştiricilerin hem de kullanıcıların farkındalığını gerektirir. Temel stratejiler şunları içerir:

· Sürekli denetimler ve kontroller: Kötü niyetli manipülasyon yahut önyargılı bilgilerin onları tehlikeye atmasını önlemek için AI/ML modellerini besleyen bilgi kümelerinin bütünlüğünü daima olarak denetim etmek ve doğrulamak değerlidir.

· Güvenliğe odaklanın: Yapay zekâ geliştiricilerinin kendileri de saldırganların gayesinde olabilir, bu nedenle proaktif tedbire, erken tespit ve sistemik güvenlik denetimleri ile hücum yüzeyini en aza indirmeye yönelik tedbire öncelikli bir yaklaşım sağlayabilecek bir güvenlik kurulumuna sahip olmak, inançlı geliştirme için olmazsa olmazdır.

· Çekişmeli eğitim: Daha evvel de belirtildiği üzere, modeller çoklukla öğrenmelerini yönlendirmek için profesyoneller tarafından denetlenir. Tıpkı yaklaşım, modellere berbat niyetli ve geçerli bilgi noktaları ortasındaki farkı öğretmek için de kullanılabilir ve sonuçta zehirleme taarruzlarının engellenmesine yardımcı olur.

· Sıfır itimat ve erişim yönetimi: Hem içeriden hem de dışarıdan gelen tehditlere karşı savunmak için bir modelin temel bilgilerine yetkisiz erişimi izleyebilen bir güvenlik tahlili kullanın. Bu formda kuşkulu davranışlar daha kolay tespit edilebilir ve önlenebilir. Ek olarak, sıfır inanç ile hiç kimseye varsayılan olarak güvenilmez ve erişim müsaadesi verilmeden evvel birden fazla doğrulama yapılması gerekir.

Kaynak: (BYZHA) Beyaz Haber Ajansı